2020 blev året där fysiska möten och even växlade över till digitala dito och precis som under normala omständigheter så avrundades årets eventserie med AWS Re:Invent.

Ett event som, precis som det fysiska, blev ett av de största och mest omfattande digitala event som någonsin hållits då alla sessioner och keynotes stäckte sig över dryga två veckor.

Ett event som, precis som det fysiska, blev ett av de största och mest omfattande digitala event som någonsin hållits då alla sessioner och keynotes stäckte sig över dryga två veckor.

En intressant tanke gällande Re:Invent var att AWS valde att basera merparten av sessionerna på Amerikansk tidszon till skillnad mot flera alternativa event under året där företagen kört alternativa sessioner för US, Europa och den Asiatiska marknaden. Rätt eller fel, om det nu finns något sådant låter vi vara osagt, men det märktes helt klart att varje session erbjöd full energi vilket vissa alternativa event inte gjort.

Som alltid så presenterades en otrolig massa nyheter inom alla tänkbara områden. Vi har här valt att lyfta fram de mest intressanta nyheterna samt sessioner och intervjuer baserade på vår inhemska marknads behov och användningsområden.

Mac in AWS

Trots Apples framfart inom både datorer, mobiler och plattor så har företagets enheter lyst med sin frånvaro när det kommit till AWS olika instanser. Men till årets event så presenterades en mycket efterlängtad nyhet i form av Mac Instances for Amazon EC2. En lösning som låter Apple utvecklare att köra äkta MacOS maskiner inom AWS för en helt ny molnbaserad pay-as-you-go lösning där utvecklare kan bygga, testa och implementera appar för iPhone, iPad, Mac, Apple Watch, Apple TV, och Safari.

Lösningen kan, precis som övriga EC2 instanser enkelt kombineras med bland annat Amazon Virtual Private Cloud (VPC) för att ge nätverkssäkerhet, Amazon Elastic Block Storage (EBS) för utökad lagringsalternativ, Amazon Elastic Load Balancer (ELB) för distribuerade kösystem för byggen och Amazon Machine Images (AMIs) för OS image orkestrering.

EC2 Mac instanserna har sin grund i en kombination av Mac-mini enheter baserade på Intel’s åttonde generations Core i7 processors med sex fysiska och tolv logiska kärnor som körs mellan 3,2GHz och 4,6 GHz samt använder 32 GiB minne — och AWS Nitro System, som ger upp till 10 Gbps av VPC nätverksbandbredd och 8 Gbps av EBS lagringsbandbredd genom höghastighets Thunderbolt 3 anslutningar.

- Vi har sedan starten jobbar hårt med att skapa en säker miljö för våra hem och närområden. Tack vare EC2 Mac-instanser blir det möjligt för oss att migrera vår Apple-infrastruktur till AWS, vilket låser upp skalbarhet, tillförlitlighet, säkerhet och kapacitet hos AWS för alla våra Apple-utvecklare. Dessa EC2 Mac-instanser låter oss också snabbt skala upp vår Mac-flotta när vi behöver det vilket förenkla apputveckling över flera plattformar genom konsolidering på en enda infrastrukturleverantör vilket i slutändan påskynda innovationer för tusentals Apple-kunder, berättar Joshua Roth, CTO, på Ring

- Våra kunder har under en tid sagt att de vill ha sin Apple-utvecklingsmiljö integrerad med AWS-tjänster. Med EC2 Mac-instanser kan utvecklare nu tillhandahålla och komma åt on-demand macOS-beräkningsmiljöer i AWS för första gången någonsin, på detta sätt kan de fokusera på att skapa banbrytande appar för Apples branschledande plattformar snarare än att skaffa och hantera den underliggande infrastrukturen säger David Brown, vice VD för EC2, på AWS.

För att börja använda EC2 Mac besök: https://aws.amazon.com/ec2/instance-types/Mac/

Industri- och tillverkningsanpassad maskininlärning

Företag letar i allt större utsträckning efter lösningar för att lägga till maskininlärningsfunktioner i industriella miljöer, såsom tillverkningsanläggningar och livsmedelsbearbetningsanläggningar. För dessa kunder har data blivit den bindväv som håller samman deras komplexa industriella system. System som likt ett spindelnät har flera simultana men sammanlänkade processer som alla är beroende av varandra för att fungera och där även minsta fel kan leda till ödesdigra konsekvenser.

För att i realtid kunna samla in data och generera realtidsmätvärden samt analysera data om system och utrustning i dessa anläggningar så har AWS lanserat fem industriella maskininlärningstjänster; Amazon Monitron, Amazon Lookout för Equipment, AWS Panorama Appliance, AWS Panorama SDK och Amazon Lookout för Vision vilket kommer att hjälpa kunderna att hantera denna utmaningen.

Tillsammans hjälper dessa fem nya maskininlärningstjänster industri- och tillverkningskunder att integrera intelligens i sina produktionsprocesser för att förbättra driftseffektivitet, kvalitetskontroll, säkerhet och säkerhet på arbetsplatsen. Tjänsterna kombinerar sofistikerad maskininlärning, sensoranalys och datorvisionsfunktioner för att hantera vanliga tekniska utmaningar som industrikunder står inför och som representerar den mest omfattande sviten av Moln-till-Edge industriella maskininlärningstjänster som finns tillgängliga. Tjänsterna för maskininlärning passar kunder i alla storlekar och inom alla branscher.

- Industri- och tillverkningskunder är ständigt under press från sina aktieägare, kunder, myndigheter och konkurrenter för att sänka kostnaderna, förbättra kvaliteten och upprätthålla regelverk. Dessa organisationer vill använda molnet och maskininlärningen för att hjälpa dem att automatisera processer samt utöka den mänskliga kapaciteten i hela sin verksamhet, men att bygga dessa system kan vara problematiskt, komplext, tidskrävande och dyrt. Vi är glada över att kunna erbjuda våra kunder dessa fem nya maskininlärningstjänster som är specialbyggda för industriellt bruk som är enkla att installera, distribuera och snabba att komma igång med och som ansluter molnet till Edgenoder för att hjälpa till att leverera framtidens smarta fabriker för våra industrikunder säger Swami Sivasubramanian, VP Maskininlärning för AWS.

- OSIsoft är en tillverkare av applikationsprogramvara för datahantering i realtid, kallad PI-systemet. Idag finns det mer än 2 miljarder sensorbaserade dataströmmar inuti OSIsoft PI Systems, och tusentals kunder litar dagligen på PI-systemet för att driva sin verksamhet. Dessa kunder letar ständigt efter metoder för att på enklast sätt ge insikter för att förbättra sin konkurrenskraft. OSIsoft-produkter kan integreras med AWS-tjänster för att hjälpa kunder att låsa upp ytterligare värde från sina data. Med bland annat Amazon Lookout for Equipment utökar omfattningen av tjänster och insikter som är tillgängliga för kunderna genom att leverera automatiserad maskininlärning byggd speciellt för utrustningskontroll, säger Michael Graves, chef of Strategic Alliances på OSIsoft.

För att lära mer om AWS nya maskininlärningstjänster besök: https://aws.amazon.com/industrial/

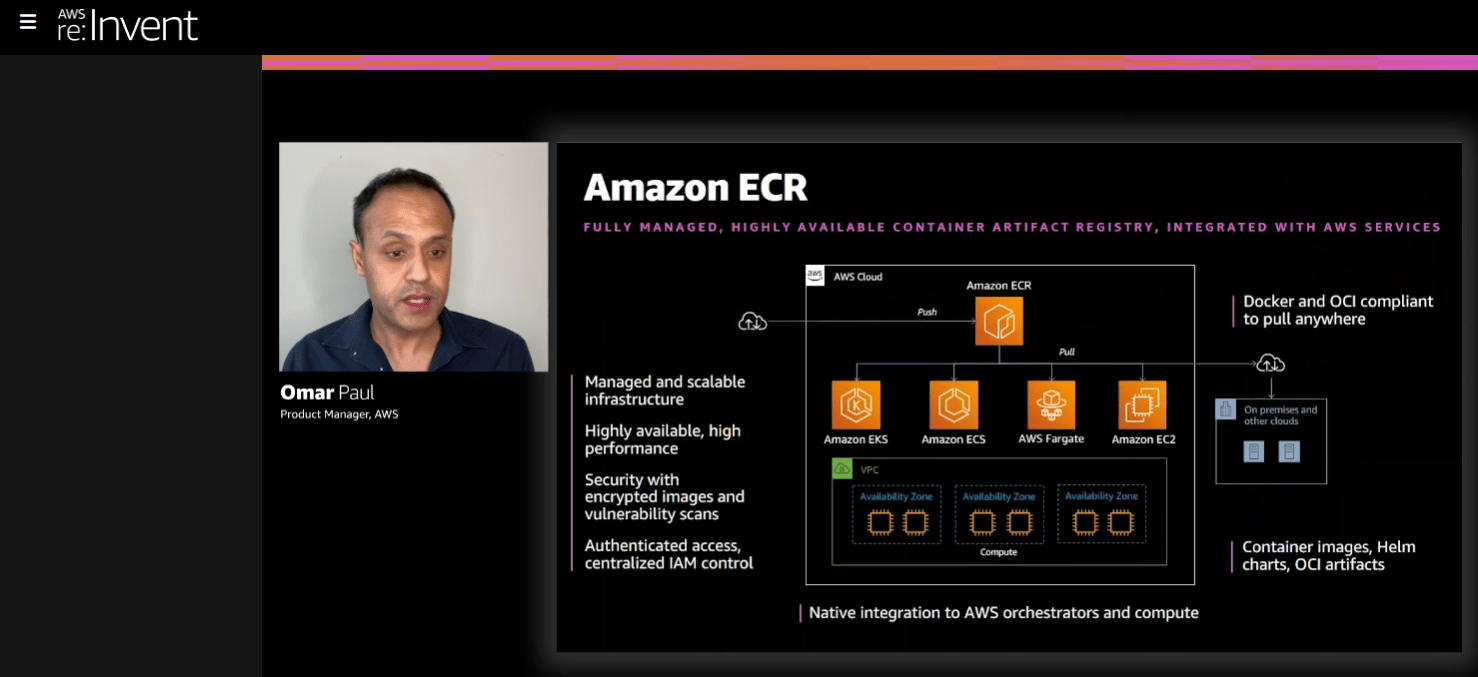

Nya containermöjligheter

Containers är ett vanligt sätt för utvecklare att paketera och köra applikationer snabbt och pålitligt i alla miljöer, samtidigt som resursutnyttjandet förbättras och kostnaden minskas. Under årets Re:Invent så presenterades fyra nya containerinnovationer som ska hjälpa kunder att utveckla, distribuera och skala moderna applikationer. Detta blir möjligt genom att kunder kan köra Amazon Elastic Container Service (ECS) eller Amazon Elastic Kubernetes Service (EKS) i sina egna datacenter, lägga till en ny tjänst för automatiserad container- och serverlös applikationsutveckling och distribution, samt tillhandahålla ett nytt containerregister som ger utvecklare ett enkelt och mycket tillgängligt sätt att dela och distribuera containerprogramvara offentligt.

De flesta företag erbjuder idag kunderna endast ett enda hanterat Kubernetes container-erbjudande vilket blir en begränsning eftersom olika utvecklare prioriterar olika behov. För att bredda dessa möjligheter så presenterades flera nya containerlösningar under årets event. För utvecklare som i första hand prioriterar att använda Kubernetes orkestrationsmotor med öppen källkod, erbjuder AWS Amazon EKS.

För utvecklare som i första hand prioriterar djupaste möjliga integrationen med övriga delar av AWS och komforten i AWS-stil-API: er samt strömlinjeformade konfigurationer för klusterhantering, schemaläggning och övervakning, erbjuder AWS Amazon ECS. Och för de kunder som föredrar att köra containrar utan att behöva tänka på servrar eller kluster alls (dvs. en serverlös miljö), erbjuder AWS, AWS Fargate. Dessa tjänster kan användas var för sig men kan även kombineras för olika arbetsbelastningar och för att möta utvecklarnas olika behov. Lösningarna kan även kombineras med AWS Proton för möjlighet att automatisera containerhanteringen.

- Kunder vill kunna köra sina arbetsbelastningar i containrar för större portabilitet, effektivare resursutnyttjande och till en lägre kostnad, till detta så har våra kunder bett AWS att göra containrar enklare att hantera, distribuera och dela. Med de nyheter som tillkännagetts under Re:Invent utökar AWS vår ledande containerfunktionalitet ytterligare genom att ge kunderna en konsekvent Amazon ECS- och Amazon EKS-upplevelse både i molnet och i sina egna datacenter. Detta gör det radikalt enklare att utveckla och distribuera container- och serverlösa applikationer och tillhandahålla en till fullo hanterad offentligt containerregister för att enklare lagra, hantera och dela containerbilder säger Deepak Singh, VP av Compute Services, AWS.

För ytterligare information besök: https://aws.amazon.com/ecs , aws.amazon.com/eks/eks-anywhere , och aws.amazon.com/proton

Nya, snabbare lagringsinovationer

För att kunna matcha de ständigt ökade kraven på lagringsprestanda och värde för kunder så presenterades fyra nya lagringslösningar, var och en med sin specifika inriktning;

- Amazon EBS io2 Block Express volumes: Den första lösning och serverarkitektur som ger SAN lösningar för molnet. En tjänst som är optimerad för prestandaintensiva applikationer som SAP HANA, Microsoft SQL Server, IBM DB2, MySQL, PostgresSQL, och Oracle databaser då tjänsten erbjuder 99,999% varaktighet och 4x mer IOPS jämfört med general purpose EBS volumer. Vilket i rena siffror motsvarar 256 000 IOPS, 4 000 MB/s genomströmning och 64TB kapacitet.

- Amazon EBS Gp3 volumes: Nästa generations SSD volymer för Amazon EBS gör det möjligt för kunder att tillföra ökade IOPS och genomströmning utan att behöva öka på lagringen i sig. Tjänsten har en hög grundnivå på 3 000 IOPS och 125 MB/s genomströmning men kan skalas upp till 16 000 IOPS respektive 1 000 MB/s. Detta är en ökning med 4x jämfört med tidigare lösningar och dessutom till en sänkt kostnad med 20 procent per GB. Tack vare en flexibel integration kan lösningen användas på en bred typ av arbetsbelastningar.

- Amazon S3 Intelligent-Tiering automatic data archiving: Med två helt nya lagringsnivåer, Archive Access och Deep Archive Access, kan kunder minska sin kostnad för lagring av data som sällan används med upp till 95% genom att automatiskt flytta denna till olika arkiveringsnivåer. Tjänsten är den första att använda en dynamisk prissättning baserad på det data som lagras och hur frekvent det används.

- Amazon S3 Replication (multi-destination): Ny kapacitet ger kunderna möjlighet att replikera data till flera S3-lagringar i samma eller olika AWS-regioner för att bättre hantera innehållsdistribution, efterlevnad och datadelningsbehov mellan regioner. Tjänsten ger även möjlighet till låg-latens prestanda då data hålls närmare den plats där åtkomst eftersträvas.

- Mer data kommer att skapas under de närmaste tre åren än vad som skapades under de senaste 30 åren. Molnet är en stor del av varför utvecklare och företag genererar och behåller så mycket data, och datalagring behöver därför delvis uppfinnas på nytt. Tillkännagivandet från årets Re;Invent återuppfinner lagring genom att bygga ett nytt SAN för molnet, vilket automatiskt hanterar kundernas data så att de kan spara pengar på det som inte behöver nås ofta, och som även gör det enkelt att replikera data och flytta den runt världen baserar på kundernas behov samt för att hantera denna nya normala lagring mer effektivt säger Mai-Lan Tomsen Bukovec, vice president, Storage, på AWS

Bättre analys för bättre insikt

Att bara samla in data har liten eller ingen betydelse. Det är först när vi drar nytta av all vårt data som vi kan få användbara insikter som kan hjälpa våra företag och snabbare anpassa tjänster och funktioner baserat på vad kunder efterfrågar. Dessa insikter behöver även tillhandahållas snabbare och snabbare och baseras på data som många gånger finns utspridd över olika platser. För att tillgodo se kundernas behov så lanserade AWS tre nya analysmöjligheter vilka gör det enklare för slutanvändare att skapa värde från sitt data oavsett vart det lagrats.

Att bara samla in data har liten eller ingen betydelse. Det är först när vi drar nytta av all vårt data som vi kan få användbara insikter som kan hjälpa våra företag och snabbare anpassa tjänster och funktioner baserat på vad kunder efterfrågar. Dessa insikter behöver även tillhandahållas snabbare och snabbare och baseras på data som många gånger finns utspridd över olika platser. För att tillgodo se kundernas behov så lanserade AWS tre nya analysmöjligheter vilka gör det enklare för slutanvändare att skapa värde från sitt data oavsett vart det lagrats.

Dessa tjänster omfattar: AQUA for Amazon Redshift som är en ny hårdvaruaccelererad cache som för beräkningskapaciteten närmare lagringen vilket accelererar frågeställningsprestandan med upp till tio gånger. Vi får även AWS Glue Elastic Views vilket är en tjänst som hjälper utvecklare att bygga applikationer som använder data från olika datalager och som automatiskt kombinerar och replikerar data över olika lagring, datalager och databaser. Dessutom presenterades Amazon QuickSight Q som tillför en maskininlärningsbaserad kapacitet för Amazons QuickSight vilket gör det möjligt för användare att använda naturliga språkuttryck vid sökningar och på detta sätt få träffsäkra svar inom enstaka sekunder.

- Med de funktioner vi tillkännagett under Re:Invent levererar vi en prestationsförbättring av storleksordning för Amazon Redshift, nya flexibla sätt att lättare flytta data mellan datalager och möjligheten för kunder att ställa naturliga språkfrågor i sin verksamhets instrumentpaneler och få svar på några sekunder. Dessa funktioner kommer att på ett meningsfullt sätt accelerera hastigheten och användarvänligheten där kunderna kan få värde av sin data oavsett datamängd och lokalitet, säger Rahul Pathak, VP, Analytics, AWS.

För ytterligare information besök: https://aws.amazon.com/big-data/datalakes-and-analytics/

En försmak på framtiden

En av de överlag mest intressanta sessionerna under hela Re:invent gällde Quantum Computing, ett område som väldigt många pratar om men som vi sällan får någon riktig information om vart utvecklingen egentligen befinner sig. Under en dryg timme pratade Simone Severini, chef för Quantum Computing på Amazon Web Services om sin och AWS syn på ämnet, vart vi befinner oss och vilken utveckling vi kan förvänta oss.

Grunden till varför Quantum Computing utvecklats kan enklast förklaras med hastighet. Sett till tiden som vissa beräkningar tar så skulle de mest extrema beräkningarna kunna ta upp mot hundra år med dagens superdatorer medan vi med en Quantum dator kan lösa samma beräkning på bara en minut. Detta gör att de potentiella användningsområdena finns överallt och för att nämna några…

- Logistik: snabbare och effektivare trafikdirigering, optimerade nätverkshantering, bättre tillverkningsflöden etc.

- Jordbruk: Tillverkning av gödselmedel med mindre energi

- Finans: bättre och snabbare riskhantering, förbättrade beslutsunderlag vid handel, val av rätt aktieportföljer mm.

- Pharma: Time to market för nya mediciner, simulerande av molekyler för framtagning av exakt rätt och stabil medicin på individnivå

- Energi: billigare och effektivare solceller och batterier med mera.

- Maskininlärning: Förstärkt inlärning, teknik som automatiskt lär av teknik

Simone Severini menar att det är viktigt att tänka på att idag Quantum datorer i första hand för forskning och för att ta fram kommande Quantum datorer som blir mer tillgängliga.

Det som i grunden gör Quantum datorer snabbare jämfört med dagens lösningar är att de lämnar den traditionella hanteringen av data där bits flyttas fram och tillbaka mellan CPU, Minne, ALU mm till en värld där Quantum använder Qubits som interagerar via vågor i realtid och behöver inte flyttas fram och tillbaka. Detta ger en aldrig tidigare skådad prestanda men ställer även nya krav på hur vi ska ställa frågor och använda systemen.

Själva processen att bygga Quantum datorer varier och det finns idag inte EN perfekt lösning utan olika tekniker testas och används för olika ändamål. Detta gör att vi nu befinner oss i lite av en testfas där inom en intervall på upp mot fem år kommer att få en bättre bild över hur de mer slutgiltiga datorerna kommer att agera vilket troligen ligger i ett tidsspann på mellan 10 och 20 år. Idag finns tre olika lösningar eller olika enheter för olika problemlösningar; D:Wave, IoniQ och Rigetti.

Quantum computing med AWS

Som väntat så erbjuder AWS redan idag flera lösningar som låter kunder testa och titta närmare på den kommande tekniken. I skrivandes stund så finns tre tjänster tillgängliga vilka är:

- Amazon Braket: En fullt hanterbar tjänst som gör det enkelt att utforska och experimentera med tekniken. Här kan forskare och utvecklare designa, testa och köra olika former av lösningar på olika Quantum baserad hårdvara. Fungerar lite som Juniper gör från AWS AI motor. Med denna tjänst kan högpresterande simuleringar utföras med upp till 34 Qubits kretsar i en serverless exekvering.

Här finns även den helt nya TN1 Tensor Network simulator som erbjuder upp till 50 Qubits vilket är den första och kraftfullaste Tensorlösningen på marknaden. - Amazon Quantum Solutions Lab: En tjänst för praktisk och tvärvetenskaplig support och samarbete för snabbare utveckling.

- AWS Center for Quantum Computing: En utvecklingsplattform för Quantum algoritmer och hårdvara

Ett steg för att skynda på steget över mot Quantum datorer är olika former av Hybridlösningar mellan både olika Quantumtekniker och så kallade Near-Term Quantum datorer. Inom detta område så lanserar AWS PennyLane on Amazon Braket. Detta är en lösning som använder traditionell och välkända ML verktyg som PyTorch och TensorFlow för att lära sig träna Quantum kretsar.

Slutligen så presenterades även nyheten AWS Research on fault tolerant Quantum architecture som är en hybrid Electro akustiks Qubit vilken har ett extremt (1000 ggr) mycket mindre fotavtryck jämfört med dagens lösningar och som erbjuder ett mycket mer effektivt schema för feltolerans vilken förbättrats med upp till tio gånger.

Detta var som nämnts bara en del av alla nyheter som presenterades och vi kommer med garanti få tillfälle att återknyta till både dessa och andra delar av AWS arbete under 2021.